Por Especialistas em Banco de Dados da dbsnOOp

A maior parte dos incidentes caros em ambientes de produção começa no banco de dados: ali se acumulam latência, locks e o desperdício de recursos. Por isso, seguem como o componente mais crítico da infraestrutura e, ao mesmo tempo, o mais frágil. Enquanto aplicações stateless em contêineres podem ser reiniciadas ou escaladas horizontalmente em segundos, o banco de dados carrega o peso do estado, da consistência e da persistência.

Para qualquer profissional sênior DBA, DevOps ou SRE, a configuração padrão de um arquivo my.cnf é somente a primeira parte de uma longa jornada. Otimizar um ambiente MySQL ou MariaDB não é um processo “instale e esqueça”; pelo contrário, é dinâmico e requer ajustes finos contra um alvo móvel: a performance volátil de um ambiente em processo de escalar ou em atualização. O crescimento exponencial do volume de dados, a arquitetura de microsserviços distribuídos e a demanda por disponibilidade de “cinco noves” (99,999%) tornaram as abordagens tradicionais obsoletas.

Uma gestão que espera o alerta de “alto consumo de CPU” ou abirem um ticket de “sistema lento” já não é mais aceitável. O custo do downtime e da latência é medido em perda direta de receita e reputação.

Diante desse contexto, escrevemos um artigo técnico para abordar os principais temas de performance no MySQL e no MariaDB. Iremos explorar as limitações humanas no tuning manual e demonstrar como a IA e a observabilidade preditiva estão redefinindo a engenharia de dados, transformando a gestão de performance em uma ciência exata e autônoma.

1. Performance no MySQL (InnoDB)

Para a vasta maioria das cargas de trabalho, performance no MySQL é centrada no InnoDB. Compreender como este storage engine gerencia memória e disco é o primeiro passo para qualquer otimização séria. O objetivo final é sempre o mesmo: reduzir o I/O físico (disco) e maximizar o I/O lógico (memória).

Gestão Avançada do Buffer Pool

O innodb_buffer_pool_size é, sem dúvida, a variável mais crítica. Ele atua como um cache para dados e índices. A regra de ouro popular sugere alocar “70-80% da RAM física” em servidores dedicados. No entanto, em engenharia de alta performance, regras gerais são perigosas.

Um Buffer Pool superdimensionado em um sistema com alta concorrência pode levar ao swapping de memória no nível do sistema operacional, o que é catastrófico para a performance do banco. Em contrapartida, um pool subdimensionado força o thrashing de páginas, no qual o InnoDB gasta ciclos excessivos lendo e descartando páginas do disco.

Validação Técnica Baseada em Dados:

Validação exige medião em detrimento de suposições. Para determinar a eficácia real da sua alocação de memória, deve-se calcular o Cache Hit Ratio.

-- Query de Diagnóstico de Eficiência do Buffer Pool

SHOW GLOBAL STATUS LIKE 'Innodb_buffer_pool_read%';

/*

INTERPRETAÇÃO DOS DADOS:

Innodb_buffer_pool_read_requests = Total de leituras lógicas (solicitadas pelo motor).

Innodb_buffer_pool_reads = Total de leituras físicas (que não estavam na memória e foram ao disco).

*/

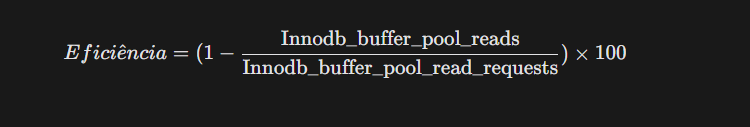

A fórmula de eficiência é:

Em ambientes de produção otimizados, este valor deve ser superior a 99,9%. Se o seu monitoramento indica 95% ou menos, seu sistema está vinculado ao desempenho do disco (I/O Bound), o que introduz latência significativa.

Redo Log e I/O Capacity

Outro gargalo frequente e mal compreendido reside nas variáveis innodb_log_file_size e innodb_io_capacity.

O InnoDB utiliza uma arquitetura de Write-Ahead Logging (WAL). As transações são escritas sequencialmente no Redo Log antes de serem aplicadas aos arquivos de dados (tablespaces). Se os arquivos de log forem muito pequenos, o MySQL precisa realizar operações de Checkpoints agressivos, forçando a escrita de páginas sujas (dirty pages) do buffer para o disco para liberar espaço no log. Isso causa picos de I/O “dente de serra” que degradam a performance da aplicação.

- Ajuste Fino: Aumentar o tamanho do log melhora a performance de escrita, pois permite mais dados na memória antes do flush.

- O Trade-off (MTTR): Arquivos de log maiores aumentam o Mean Time To Recovery (MTTR). Se o banco falhar, o InnoDB levará mais tempo para repassar o log e recuperar o estado consistente.

2. Otimização de Queries e Indexação

Não há hardware ou ajuste de my.cnf que salve uma query mal escrita. Os maiores ganhos de performance são encontrados ao otimizar SQL, frequentemente na ordem de 10 a 100 vezes mais.

Covering Indexes

Muitos desenvolvedores entendem o índice básico em uma cláusula WHERE. Porém, especialistas utilizam Índices de Cobertura.

Quando um índice contém todas as colunas solicitadas por uma consulta (no SELECT, JOIN, WHERE e ORDER BY), o banco de dados pode recuperar os resultados lendo apenas a estrutura da árvore B-Tree do índice, sem nunca tocar na tabela principal (Clustered Index). Isso economiza operações massivas de I/O aleatório.

Estudo de Caso Técnico:

Imagine uma tabela orders com milhões de linhas.

Query Problema:

SELECT customer_id, total_amount, order_date

FROM orders

WHERE status = 'shipped'

ORDER BY order_date DESC;

Se houver um índice apenas em status, o MySQL fará o filtro, mas terá que realizar um lookup na tabela principal para buscar total_amount e order_date para cada linha encontrada, e depois realizar um filesort para ordenar.

Solução com Índice de Cobertura:

CREATE INDEX idx_covering ON orders (status, order_date, customer_id, total_amount);

Com este índice composto, o MySQL executa a query inteira apenas percorrendo o índice. O EXPLAIN mostrará Using index na coluna Extra, o “Santo Graal” da otimização SQL.

Planos de Execução (EXPLAIN)

A leitura correta do EXPLAIN é a habilidade que separa juniores de seniores.

- type: ALL: Full Table Scan. O banco leu a tabela inteira. Aceitável em tabelas minúsculas, desastroso em grandes volumes.

- type: index: Full Index Scan. O banco leu o índice inteiro. Melhor que ler a tabela, mas ainda lento.

- type: ref / eq_ref: O banco usou o índice para encontrar linhas específicas. O ideal.

- Extra: Using temporary; Using filesort: Indicadores críticos de degradação. O banco precisou criar estruturas temporárias em disco para resolver a query.

3. Conexões em Estado de Sleep

Então tem problemas com conexões inativas, correto? Também costumava-se chamá-las de conexões irritantes.

Em primeiro lugar, temos a variável max_connections. Essa é a limitação de conexões gerenciáveis que seu servidor fará. Se você definir max_connections como 100, por exemplo, nenhuma conexão acima da 100ª será permitida. Se o servidor mantiver abertas as que nunca são utilizadas novamente, isso é um problema a ser atendido.

Muitas conexões com o banco de dados, normalmente, indicam que a aplicação está com falhas ou que a aplicação não foi bem projetada. Aplicações muito específicas realmente precisam abrir várias. Qual é! Use pools de conexão pelo amor de Deus!

Lembre-se de que cada conexão inativa tem um consumo mínimo de recursos, como memória, por exemplo. O consumo mínimo de memória por conexão é cerca de 192 KB a 256 KB, mas isso depende do que acontece quando a conexão é encerrada.

O que pode levar a uma conexão em estado de sleep?

- Handshaking inadequado;

- Falha de rede;

- Falha na aplicação;

- Falha no gerenciador de;

- Equívoco de programação.

Se você notar muitas conexões em estado de sleep no seu servidor MySQL, é necessário dedicar algum tempo para investigar. O dbsnOOp oferece meios para rastreá-las e ferramentas úteis para combater as que estão inativas.

4. MariaDB e a Complexidade de Sistemas Distribuídos

O MariaDB evoluiu para além de uma simples ramificação ou spin-off do MySQL. Com a introdução do Galera Cluster, ele oferece replicação síncrona multi-mestre, que etraz alta disponibilidade real, mas introduz uma nova classe de desafios de performance.

Galera Cluster

Diferente da replicação assíncrona tradicional do MySQL (Source-Replica), onde o atraso (seconds_behind_master) é tolerado, o Galera garante consistência estrita. No entanto, o teorema CAP nos lembra que consistência e disponibilidade em partição de rede têm um preço: latência.

Flow Control

No caso de um cluster síncrono, a velocidade de escrita do cluster é definida pelo nó mais lento. Se um nó (Nó C) estiver sofrendo com alta carga de CPU ou disco lento, ele não conseguirá aplicar os writesets na mesma velocidade que os outros nós.

Para evitar inconsistência, o Galera ativa o mecanismo de Flow Control. O nó lento envia um sinal para pausar a replicação em todos os outros nós.

- Sintoma: A aplicação experimenta “congelamentos” intermitentes nas escritas, mesmo que os outros nós do banco estejam ociosos.

- Diagnóstico: Monitorar a variável wsrep_flow_control_paused. Se este valor for maior que 0.0, seu cluster está sendo estrangulado por um membro doente.

Concorrência e Falhas de Certificação

Em arquiteturas multi-mestre, escritas simultâneas na mesma linha em nós diferentes resultam em conflito. O Galera resolve isso através da Certificação Otimista (optimistic rollup): a primeira transação a chegar ao estágio de commit vence, enquanto a outra transação recebe um erro de Deadlock e é abortada.

Saiba mais sobre Locks e Deadlocks aqui

Monitorar wsrep_local_cert_failures é essencial. Um número alto indica que a arquitetura da aplicação não está otimizada para multi-mestre (“Hot Rows”), exigindo refatoração ou particionamento de carga.

5. O Limite Humano

Até aqui, discutimos técnicas manuais profundas. O problema é que, na escala atual, a aplicação manual dessas técnicas é inviável.

- Você não pode monitorar wsrep_flow_control_paused 24/7.

- Você não pode revisar o EXPLAIN de cada nova query introduzida em cada deploy de microsserviços.

- Você não pode correlacionar manualmente picos de I/O com mudanças de comportamento de usuários em tempo real.

É aqui que a Engenharia de Plataforma encontra a Inteligência Artificial. Ferramentas como o dbsnOOp não são apenas painéis de visualização; são sistemas de Observabilidade Preditiva.

Baselines Dinâmicos

O monitoramento tradicional alerta se a CPU passar de 90%. A IA do dbsnOOp aprende o comportamento “normal” do seu banco: se a CPU atinge 50% às 3 da manhã (quando deveria ser 5%), isso é uma anomalia grave, talvez um vazamento de dados ou um job fantasma. Um monitoramento tradicional ignoraria isso enquanto a IA alerta porque entende o contexto e a sazonalidade.

Análise de Causa Raiz (RCA) Automatizada

Quando um incidente ocorre, o tempo médio de reparo (MTTR) é a métrica mais importante. Um humano leva tempo para logar na VPN, abrir o terminal, rodar top, entrar no MySQL, verificar a processlist, checar o error log e correlacionar os dados.

O Copilot da dbsnOOp faz isso instantaneamente. Ele correlaciona:

- A degradação de performance da aplicação.

- Com um pico de Lock Wait no banco.

- Identifica a query exata (SQL_ID) causadora do bloqueio.

- Identifica quem executou (User/Host).

- Sugere a ação (ex: KILL QUERY ou criar índice).

Em vez de dizer “O banco está lento”, a IA diz: “A query X está bloqueando a tabela Y, causando fila no Galera Cluster e elevando o tempo de resposta da API de Pagamentos em 400%.”

Otimização Proativa

O grande volume de queries executadas por segundo (QPS) em um ambiente de produção torna inviável a análise manual de cada comando SQL. Em geral, ferramentas de monitoramento padrão geram um “Top Queries”. No entanto, saber qual query é lenta representa apenas metade do trabalho na otimização do MySQL.

Nesse contexto, o dbsnOOp integra Inteligência Artificial prescritiva. Ao detectar uma query que degrada a performance, o sistema não apenas a exibe em um dashboard, como também analisa o plano de execução (EXPLAIN). A IA identifica, por exemplo, que uma consulta realiza um full table scan em uma tabela com milhões de registros devido à ausência de um índice composto. A ferramenta então prescreve a solução – “Crie o índice X na coluna Y” – e oferece uma versão otimizada, pronta para ser copiada, colada ou executada diretamente pela plataforma. Além disso, o dbsnOOp aguarda o momento mais adequado para aplicar a correção, sem comprometer a estabilidade do ambiente MySQL.

Evolução Necessária

A garantia da eficiência operacional é um fator chave na gestão de MySQL e MariaDB. As variáveis são muitas, a complexidade é alta e a velocidade de mudança é implacável.

Tentar gerenciar bancos de dados modernos apenas com scripts manuais e intuição humana é um risco operacional inaceitável. A união do conhecimento profundo sobre a arquitetura interna do banco de dados (InnoDB, Galera, Indexação) com a potência da Inteligência Artificial da dbsnOOp cria uma sinergia poderosa.

Isso libera os engenheiros seniores das tarefas repetitivas de “apagar incêndios” e permite que foquem na arquitetura, na inovação e na estratégia de dados.

Não espere o próximo incidente expor as fragilidades da sua monitorização. Eleve sua maturidade operacional.

Saiba mais sobre o dbsnOOp!

Visite nosso canal no youtube e aprenda sobre a plataforma e veja tutoriais

Aprenda sobre monitoramento de banco de dados com ferramentas avançadas aqui.

Leitura Recomendada

- SRE para Bancos de Dados: Guia Prático de Implementação (DBRE): Entenda a evolução do papel do DBA para o Engenheiro de Confiabilidade de Banco de Dados. Este guia prático discute como aplicar os princípios de SRE à camada de dados, focando em automação, SLOs e colaboração com as equipes de desenvolvimento.

- Indústria 4.0 e IA: O Desafio da Performance do Banco de Dados e a Importância da Observabilidade: Explore como as demandas da Indústria 4.0, IoT e Inteligência Artificial estão elevando a complexidade e o volume de dados a novos patamares. Este artigo discute por que as ferramentas de monitoramento legado são insuficientes neste novo cenário e como a observabilidade se torna crucial para garantir a performance e a escalabilidade necessárias para a inovação.

- Performance Tuning: como aumentar velocidade sem gastar mais hardware: Antes de aprovar o upgrade de uma instância, é fundamental esgotar as otimizações de software. Este guia foca em técnicas de performance tuning que permitem extrair o máximo de desempenho do seu ambiente atual, resolvendo a causa raiz da lentidão em queries e índices, em vez de apenas remediar os sintomas com hardware mais caro.